Servers in stock

Checking availability...

-

Dank ihrer geringen Latenz eignen sich TPUs für Anwendungen, die Echtzeitvorhersagen erfordern, wie beispielsweise Empfehlungssysteme und Betrugserkennungssysteme.

TPUs sind für das Training komplexer Modelle wie GPT-4 und BERT optimiert, wodurch Trainingszeit und -kosten reduziert werden.

Akademische und unternehmerische Forscher nutzen TPUs für Aufgaben wie Klimamodellierung und Proteinfaltungssimulationen und profitieren dabei von ihrer Rechenleistung und Effizienz.

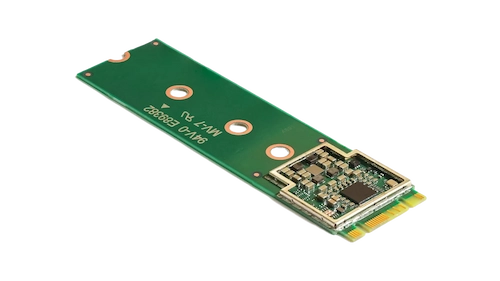

Dieser kompakte Beschleuniger verbessert das maschinelle Lernen auf dem Gerät, indem er Hochgeschwindigkeitsinferenzen bei geringem Stromverbrauch ermöglicht.

Durch die Integration des Coral M.2 Accelerators in Ihr System erreichen Sie eine effiziente Echtzeit-Verarbeitung von maschinellem Lernen direkt auf dem Gerät, wodurch Latenzzeiten und die Abhängigkeit von Cloud-basierten Berechnungen reduziert werden.

Der Hailo-8 Edge-KI-Prozessor liefert bis zu 26 Tera-Operationen pro Sekunde (TOPS) in einem kompakten Formfaktor, der kleiner als ein Cent ist, einschließlich seines Speichers.

Seine für neuronale Netze optimierte Architektur ermöglicht effizientes Deep Learning in Echtzeit auf Edge-Geräten bei minimalem Stromverbrauch und ist somit ideal für Anwendungen in der Automobilindustrie, in Smart Cities und in der industriellen Automatisierung.

Dieses Design ermöglicht eine leistungsstarke KI-Verarbeitung am Netzwerkrand bei gleichzeitiger Reduzierung von Kosten und Energieverbrauch.

TPUs sind speziell für matrixintensive Berechnungen konzipiert und ermöglichen im Vergleich zu herkömmlichen GPUs schnellere Trainings- und Inferenzzeiten.

Ermöglicht verteiltes Training über mehrere Einheiten hinweg. Diese Skalierbarkeit ist entscheidend für das effiziente Training großer Modelle.

Unterstützung gängiger Machine-Learning-Frameworks wie TensorFlow, PyTorch (über OpenXLA) und JAX, wodurch eine nahtlose Integration in bestehende Arbeitsabläufe ermöglicht wird.

TPUs sind in Dienste wie Google Kubernetes Engine (GKE) und Vertex AI integriert und ermöglichen so eine einfache Orchestrierung und Verwaltung von KI-Workloads.