Servers in stock

Checking availability...

-

Gracias a sus capacidades de baja latencia, las TPU son adecuadas para aplicaciones que requieren predicciones en tiempo real, como motores de recomendación y sistemas de detección de fraude.

Las TPU están optimizadas para entrenar modelos complejos como GPT-4 y BERT, reduciendo el tiempo y el coste de entrenamiento.

Los investigadores académicos y empresariales utilizan las TPU para tareas como la modelización climática y las simulaciones de plegamiento de proteínas, beneficiándose de su potencia computacional y eficiencia.

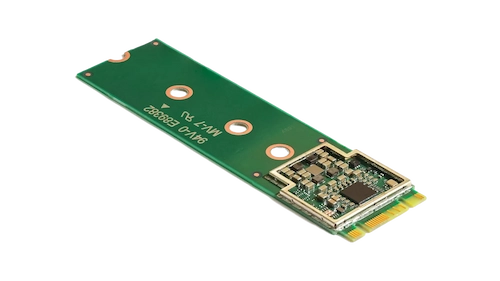

Este acelerador compacto mejora el aprendizaje automático en el dispositivo al permitir la inferencia de alta velocidad con un bajo consumo de energía.

Al incorporar el acelerador Coral M.2 a su sistema, puede lograr un procesamiento de aprendizaje automático eficiente y en tiempo real directamente en el dispositivo, reduciendo la latencia y la dependencia de los cálculos basados en la nube.

El procesador de IA de borde Hailo-8 ofrece hasta 26 teraoperaciones por segundo (TOPS) en un formato compacto más pequeño que un centavo, incluyendo su memoria.

Su arquitectura, optimizada para redes neuronales, permite un aprendizaje profundo eficiente y en tiempo real en dispositivos periféricos con un consumo de energía mínimo, lo que la hace ideal para aplicaciones en automoción, ciudades inteligentes y automatización industrial.

Este diseño permite un procesamiento de IA de alto rendimiento en el borde, al tiempo que reduce los costes y el consumo de energía.

Las TPU están diseñadas específicamente para cálculos con gran cantidad de matrices, ofreciendo tiempos de entrenamiento e inferencia más rápidos en comparación con las GPU tradicionales.

Permite el entrenamiento distribuido en múltiples unidades. Esta escalabilidad es crucial para entrenar modelos grandes de manera eficiente.

Admite los principales marcos de aprendizaje automático, incluidos TensorFlow, PyTorch (a través de OpenXLA) y JAX, lo que permite una integración perfecta en los flujos de trabajo existentes.

Las TPU están integradas con servicios como Google Kubernetes Engine (GKE) y Vertex AI, lo que facilita la orquestación y gestión de cargas de trabajo de IA.