Servers in stock

Checking availability...

-

Configurations Nvidia A100 H100, parfaites pour l'IA, l'apprentissage profond, la visualisation et le calcul haute performance.

Disques NVMe

Assistance 24h/24 et 7j/7

Prix imbattables

Déploiement en 5 minutes

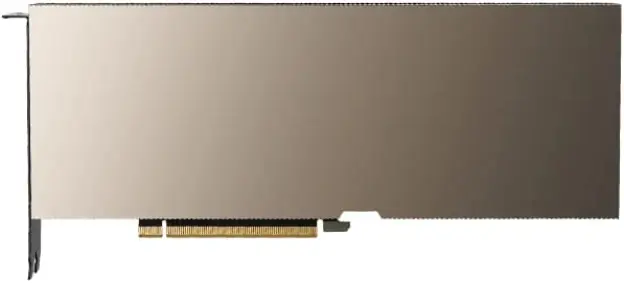

GPU NVIDIA A100

| Caractéristiques techniques de la carte graphique NVIDIA A100 : | |

|---|---|

| Capacité de mémoire vidéo | 40 Go / 80 Go HBM2 |

| cœurs CUDA | 6912 pièces. |

| Bande passante maximale | 1,6 To/s |

| Les GPU Nvidia A100 offrent les performances, l'évolutivité et l'efficacité nécessaires aux applications d'IA et d'apprentissage profond, ce qui en fait une excellente option pour les entreprises et les chercheurs à la recherche d'une puissance de calcul de pointe. | |

Infrastructure Ampere

Avec ses 54 milliards de transistors, l'architecture NVIDIA Ampere est l'une des plus grandes puces 7 nanomètres jamais construites.

Mémoire à large bande passante (HBM2)

La mémoire HBM2 est conçue pour offrir un accès rapide et efficace aux données, avec une bande passante mémoire allant jusqu'à 1,6 To/s.

IA et apprentissage profond

La carte graphique Nvidia A100 est spécialement conçue pour les applications d'intelligence artificielle et d'apprentissage profond, offrant des performances jusqu'à 20 fois supérieures à celles des GPU de la génération précédente.

lancer de rayons

Découvrez le ray tracing en temps réel, idéal pour les tâches de visualisation les plus exigeantes. Le GPU A100 offre la puissance de rendu nécessaire pour des visuels réalistes et immersifs.

Prise en charge NVLink

Exploitez les capacités de la technologie NVLink de 3e génération pour des transferts de données ultra-rapides, jusqu'à 10 à 20 fois plus rapides que PCI-Express.

GPU multi-interface

Autoriser chaque GPU A100 à exécuter simultanément sept applications ou sessions utilisateur distinctes et isolées.

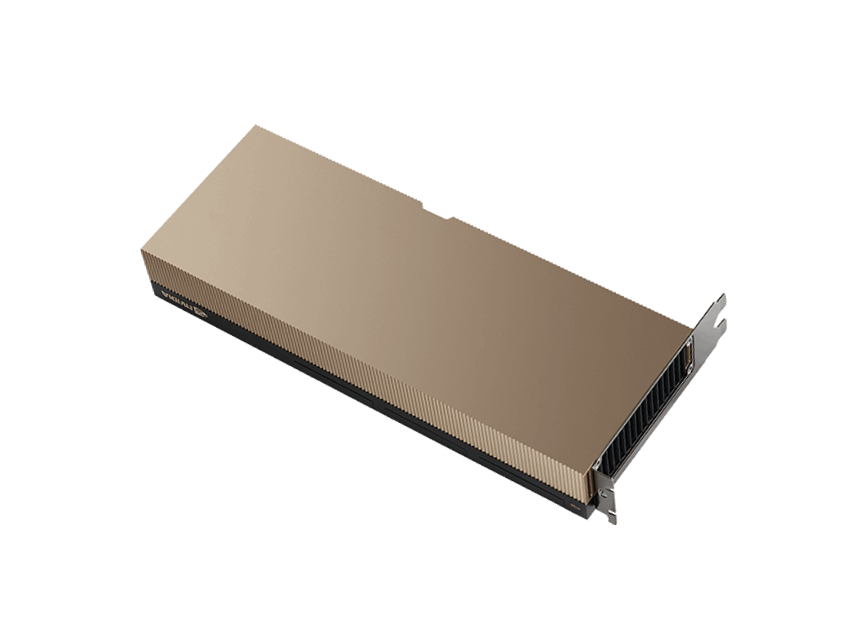

GPU NVIDIA H100

| Caractéristiques techniques de la carte graphique NVIDIA H100 : | |

|---|---|

| Capacité de mémoire vidéo | 80 Go HBM3 |

| cœurs CUDA | 8448 pièces. |

| Bande passante maximale | 3 To/s |

| Le tout nouveau GPU NVIDIA H100 offre des performances, une évolutivité et une sécurité sans précédent pour diverses charges de travail. Il est au moins deux fois plus rapide que son prédécesseur, le GPU A100. | |

Infrastructure de trémie

Les GPU H100 offrent des performances exceptionnelles dans les applications HPC, 7 fois supérieures à celles des GPU A100.

Connectivité

Il est possible de connecter jusqu'à 256 GPU H100 via le système de commutation NVIDIA NVLink, ce qui permet d'accélérer les tâches exascale.

formation en IA

Le GPU H100 représente la quatrième génération du système d'IA le plus avancé, offrant des performances exceptionnelles.

GPU multi-interface

Le H100 est doté de la technologie MIG de deuxième génération, qui permet de partitionner chaque GPU en toute sécurité jusqu'à sept instances distinctes.

Pourquoi Primcast ?

Livraison rapide

Les configurations Instant A100 sont livrées en 5 minutes, après vérification de votre paiement.

99,9 % sla

Votre serveur dédié GPU bénéficie d'un SLA de pointe, garantissant une disponibilité de 99,9 %.

Assistance 24h/24 et 7j/7

Des experts en GPU cloud sont disponibles en direct par chat, téléphone et e-mail.

centres de données

Déployez votre serveur dédié NVIDIA A100 depuis New York, Miami, San Francisco, Amsterdam ou Bucarest.