Servers in stock

Checking availability...

-

Configurazioni Nvidia A100 H100, perfette per intelligenza artificiale, deep learning, visualizzazione e calcolo ad alte prestazioni.

Dischi NVMe

Supporto 24 ore su 24, 7 giorni su 7

Prezzi imbattibili

5 minuti di distribuzione

Scheda grafica NVIDIA A100

| Specifiche NVIDIA A100: | |

|---|---|

| Capacità di memoria video | HBM2 da 40 GB / 80 GB |

| Core CUDA | 6912 pezzi |

| Larghezza di banda massima | 1,6 TB/s |

| Le GPU Nvidia A100 offrono le prestazioni, la scalabilità e l'efficienza necessarie per le applicazioni di intelligenza artificiale e deep learning, il che le rende un'opzione eccellente per aziende e ricercatori alla ricerca di una potenza di calcolo all'avanguardia. | |

Infrastruttura Ampere

Con 54 miliardi di transistor, l'architettura NVIDIA Ampere è uno dei più grandi chip da 7 nanometri mai costruiti.

Memoria ad alta larghezza di banda (HBM2)

HBM2 è progettato per offrire un accesso ai dati rapido ed efficace, con una larghezza di banda di memoria fino a 1,6 TB/s.

Intelligenza artificiale e apprendimento profondo

La Nvidia A100 è progettata specificamente per applicazioni di intelligenza artificiale e deep learning, offrendo prestazioni fino a 20 volte superiori rispetto alle GPU di precedente generazione.

Tracciamento dei raggi

Prova il ray tracing in tempo reale, ideale per le attività di visualizzazione più impegnative. La GPU A100 offre la potenza di rendering necessaria per immagini realistiche e immersive.

Supporto NVLink

Sfrutta le capacità della tecnologia NVLink di terza generazione per trasferimenti di dati rapidissimi, da 10 a 20 volte più rapidi rispetto a PCI-Express.

GPU multi-interfaccia

Consenti a ciascuna GPU A100 di eseguire simultaneamente sette applicazioni o sessioni utente distinte e isolate.

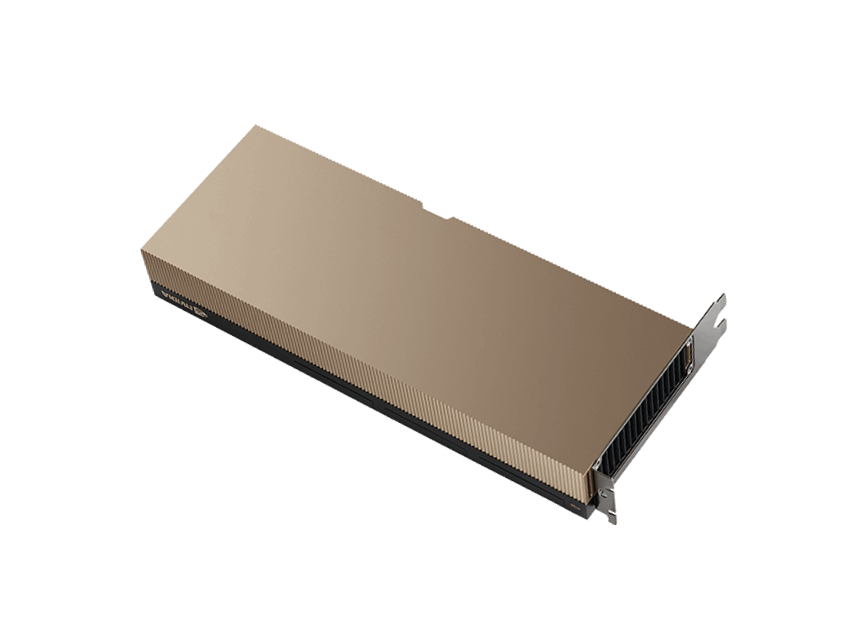

GPU NVIDIA H100

| Specifiche NVIDIA H100: | |

|---|---|

| Capacità di memoria video | 80 GB HBM3 |

| Core CUDA | 8448 pezzi |

| Larghezza di banda massima | 3 TB/s |

| L'ultima GPU NVIDIA H100 lanciata sul mercato offre prestazioni, scalabilità e sicurezza senza precedenti per vari carichi di lavoro. È almeno due volte più veloce della GPU A100, la precedente. | |

Infrastruttura Hopper

Le GPU H100 garantiscono prestazioni eccezionali nelle applicazioni HPC, 7 volte superiori rispetto alle GPU A100.

Connettività

È possibile collegare fino a 256 GPU H100 utilizzando il sistema NVIDIA NVLink Switch, consentendo di accelerare le attività exascale.

Formazione sull'intelligenza artificiale

La GPU H100 rappresenta la quarta generazione del sistema di intelligenza artificiale più avanzato, offrendo prestazioni eccezionali.

GPU multi-interfaccia

L'H100 è dotato della tecnologia MIG di seconda generazione, che consente di suddividere in modo sicuro ciascuna GPU in un massimo di sette istanze separate.

Perché Primcast?

Consegna veloce

Le configurazioni istantanee dell'A100 vengono consegnate entro 5 minuti, previo pagamento verificato.

99,9% sla

Il tuo server GPU dedicato è supportato da un SLA leader del settore, con un uptime del 99,9%.

Supporto 24 ore su 24, 7 giorni su 7

Gli esperti di cloud GPU in tempo reale sono disponibili tramite chat, telefono ed e-mail.

centri dati

Distribuisci il tuo server dedicato NVIDIA A100 da New York, Miami, San Francisco, Amsterdam o Bucarest.