Servers in stock

Checking availability...

-

Grazie alle loro capacità di bassa latenza, le TPU sono adatte ad applicazioni che richiedono previsioni in tempo reale, come motori di raccomandazione e sistemi di rilevamento delle frodi.

Le TPU sono ottimizzate per l'addestramento di modelli complessi come GPT-4 e BERT, riducendo tempi e costi di addestramento.

I ricercatori accademici e aziendali utilizzano le TPU per attività quali la modellazione climatica e le simulazioni del ripiegamento delle proteine, traendo vantaggio dalla loro potenza di calcolo e dalla loro efficienza.

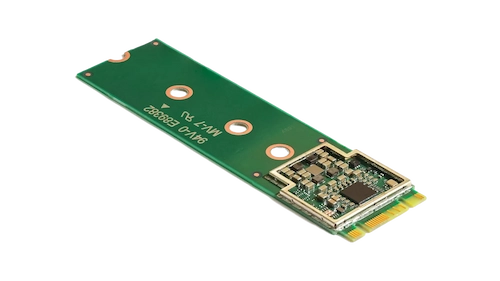

Questo acceleratore compatto migliora l'apprendimento automatico sul dispositivo consentendo inferenze ad alta velocità con un basso consumo energetico.

Integrando Coral M.2 Accelerator nel tuo sistema, puoi ottenere un'elaborazione di apprendimento automatico efficiente e in tempo reale direttamente sul dispositivo, riducendo la latenza e la dipendenza dai calcoli basati sul cloud.

Il processore AI edge Hailo-8 offre fino a 26 tera-operazioni al secondo (TOPS) in un formato compatto, più piccolo di un centesimo, memoria inclusa.

La sua architettura, ottimizzata per le reti neurali, consente un apprendimento approfondito efficiente e in tempo reale su dispositivi edge con un consumo energetico minimo, rendendolo ideale per applicazioni nei settori automobilistico, delle città intelligenti e dell'automazione industriale.

Questa progettazione consente l'elaborazione AI ad alte prestazioni in periferia, riducendo al contempo i costi e il consumo energetico.

Le TPU sono progettate appositamente per calcoli che coinvolgono molte matrici, garantendo tempi di addestramento e inferenza più rapidi rispetto alle GPU tradizionali.

Consente l'addestramento distribuito su più unità. Questa scalabilità è fondamentale per addestrare in modo efficiente modelli di grandi dimensioni.

Supporta i principali framework di apprendimento automatico, tra cui TensorFlow, PyTorch (tramite OpenXLA) e JAX, consentendo un'integrazione perfetta nei flussi di lavoro esistenti.

Le TPU sono integrate con servizi come Google Kubernetes Engine (GKE) e Vertex AI, facilitando l'orchestrazione e la gestione dei carichi di lavoro di intelligenza artificiale.