Servers in stock

Checking availability...

Konfiguracje Nvidia A100 H100, idealne do zastosowań w sztucznej inteligencji, uczeniu głębokim, wizualizacji i obliczeniach o wysokiej wydajności.

Dyski NVMe

Wsparcie 24/7

Bezkonkurencyjne ceny

5 minut rozmieszczenia

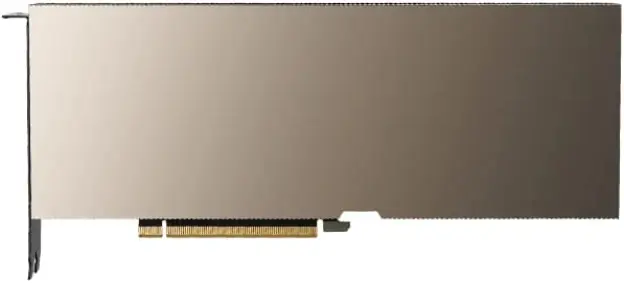

Procesor graficzny NVIDIA A100

| Specyfikacja NVIDIA A100: | |

|---|---|

| Pojemność pamięci wideo | 40 GB / 80 GB HBM2 |

| Rdzenie CUDA | 6912 szt. |

| Maksymalna przepustowość | 1,6 TB/s |

| Procesory graficzne Nvidia A100 zapewniają wydajność, skalowalność i efektywność niezbędne w aplikacjach z zakresu sztucznej inteligencji i głębokiego uczenia, dzięki czemu stanowią doskonałą opcję dla firm i badaczy poszukujących najnowocześniejszej mocy obliczeniowej. | |

Infrastruktura Ampere

Składająca się z 54 miliardów tranzystorów architektura NVIDIA Ampere jest jednym z największych układów scalonych o technologii 7 nanometrów, jakie kiedykolwiek zbudowano.

Pamięć o dużej przepustowości (HBM2)

Pamięć HBM2 została zaprojektowana tak, aby zapewnić szybki i efektywny dostęp do danych, z przepustowością pamięci do 1,6 TB/s.

Sztuczna inteligencja i głębokie uczenie

Karta graficzna Nvidia A100 została zaprojektowana specjalnie z myślą o zastosowaniach sztucznej inteligencji i głębokiego uczenia, zapewniając nawet 20-krotnie większą wydajność niż poprzednie generacje procesorów graficznych.

Śledzenie promieni

Doświadcz ray tracingu w czasie rzeczywistym, idealnego do wymagających zadań wizualizacyjnych. Procesor graficzny A100 zapewnia moc renderowania niezbędną do tworzenia realistycznych i wciągających wizualizacji.

Obsługa NVLink

Wykorzystaj możliwości technologii NVLink trzeciej generacji, aby uzyskać błyskawiczne transfery danych — od 10 do 20 razy szybsze niż w przypadku PCI-Express.

Wielointerfejsowy procesor graficzny

Umożliwia każdemu procesorowi graficznemu A100 równoczesne uruchamianie siedmiu odrębnych i odizolowanych aplikacji lub sesji użytkownika.

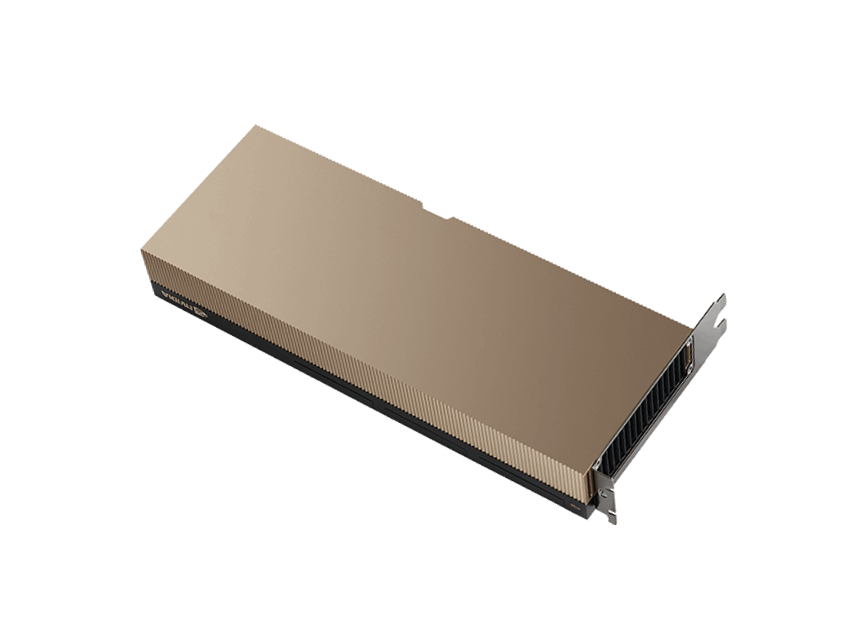

Procesor graficzny NVIDIA H100

| Specyfikacja NVIDIA H100: | |

|---|---|

| Pojemność pamięci wideo | 80 GB HBM3 |

| Rdzenie CUDA | 8448 szt. |

| Maksymalna przepustowość | 3 TB/s |

| Najnowszy procesor graficzny NVIDIA H100 oferuje bezprecedensową wydajność, skalowalność i bezpieczeństwo dla różnych obciążeń. Jest co najmniej dwa razy szybszy niż jego poprzednik, procesor graficzny A100. | |

Infrastruktura leja

Procesory graficzne H100 zapewniają znakomitą wydajność w aplikacjach HPC – 7-krotnie wyższą w porównaniu do procesorów graficznych A100.

Łączność

Za pomocą systemu przełączania NVIDIA NVLink można połączyć maksymalnie 256 procesorów graficznych H100, co pozwala na przyspieszenie zadań eksaskalowych.

Szkolenie AI

Procesor graficzny H100 reprezentuje czwartą generację najbardziej zaawansowanego systemu sztucznej inteligencji, oferującego wyjątkową wydajność.

Wielointerfejsowy procesor graficzny

W urządzeniu H100 zastosowano technologię MIG drugiej generacji, która umożliwia bezpieczne partycjonowanie każdego procesora graficznego na maksymalnie siedem osobnych instancji.

Dlaczego Primcast?

Szybka dostawa

Konfiguracje A100 dostarczane są w ciągu 5 minut po zweryfikowaniu płatności.

99,9% sla

Twój serwer dedykowany GPU jest objęty wiodącą w branży umową SLA z 99,9% czasem sprawności.

Wsparcie 24/7

Nasi eksperci ds. chmury GPU są dostępni na czacie na żywo, telefonicznie i e-mailem.

Centra danych

Wdróż swój dedykowany serwer NVIDIA A100 z Nowego Jorku, Miami, San Francisco, Amsterdamu lub Bukaresztu.