Servers in stock

Checking availability...

-

Cu capacități de latență redusă, TPU-urile sunt potrivite pentru aplicații care necesită predicții în timp real, cum ar fi motoarele de recomandări și sistemele de detectare a fraudelor.

TPU-urile sunt optimizate pentru antrenarea modelelor complexe precum GPT-4 și BERT, reducând timpul și costurile de antrenament.

Cercetătorii academici și din mediul de afaceri utilizează TPU-uri pentru sarcini precum modelarea climatică și simulările de pliere a proteinelor, beneficiind de puterea și eficiența lor de calcul.

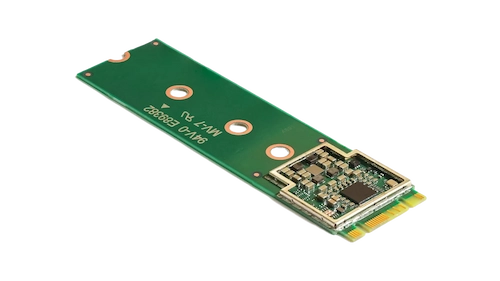

Acest accelerator compact îmbunătățește învățarea automată pe dispozitiv, permițând inferențe de mare viteză cu un consum redus de energie.

Prin încorporarea Coral M.2 Accelerator în sistemul dvs., puteți obține o procesare eficientă, în timp real, a învățării automate direct pe dispozitiv, reducând latența și dependența de calculele bazate pe cloud.

Procesorul de inteligență artificială Hailo-8 edge oferă până la 26 de tera-operații pe secundă (TOPS) într-un factor de formă compact, mai mic decât un bănuț, inclusiv memoria.

Arhitectura sa, optimizată pentru rețele neuronale, permite învățarea profundă eficientă, în timp real, pe dispozitive edge, cu un consum minim de energie, ceea ce o face ideală pentru aplicații în industria auto, orașe inteligente și automatizări industriale.

Acest design permite procesarea de înaltă performanță prin inteligență artificială la marginea rețelei, reducând în același timp costurile și consumul de energie.

TPU-urile sunt special concepute pentru calcule cu matrice grea, oferind timpi de antrenament și inferență mai rapizi în comparație cu GPU-urile tradiționale.

Permite antrenamentul distribuit pe mai multe unități. Această scalabilitate este crucială pentru antrenarea eficientă a modelelor mari.

Suportă principalele framework-uri de învățare automată, inclusiv TensorFlow, PyTorch (prin OpenXLA) și JAX, permițând integrarea perfectă în fluxurile de lucru existente.

TPU-urile sunt integrate cu servicii precum Google Kubernetes Engine (GKE) și Vertex AI, facilitând orchestrarea și gestionarea ușoară a sarcinilor de lucru bazate pe inteligență artificială.