Servers in stock

Checking availability...

Nvidia A100 H100 配置,非常适合人工智能、深度学习、可视化和高性能计算。

NVMe 磁盘

全天候支持

无与伦比的价格

5分钟部署

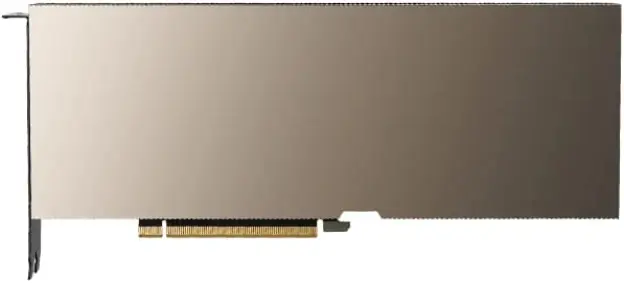

NVIDIA A100 GPU

| NVIDIA A100 规格: | |

|---|---|

| 视频内存容量 | 40GB / 80GB HBM2 |

| CUDA核心 | 6912 件 |

| 最大带宽 | 1.6 TB/s |

| Nvidia A100 GPU 具备人工智能和深度学习应用所需的性能、可扩展性和效率,是寻求尖端计算能力的企业和研究人员的绝佳选择。 | |

安培基础设施

NVIDIA Ampere 架构拥有 540 亿个晶体管,是迄今为止制造的最大的 7 纳米芯片之一。

高带宽内存(HBM2)

HBM2 旨在提供快速有效的数据访问,内存带宽高达 1.6 TB/s。

人工智能和深度学习

Nvidia A100 专为人工智能和深度学习应用而设计,其性能是上一代 GPU 的 20 倍。

光线追踪

体验实时光线追踪,是高要求可视化任务的理想之选。A100 GPU 提供逼真沉浸式视觉效果所需的强大渲染能力。

NVLink 支持

利用第三代 NVLink 的强大功能,实现比 PCI-Express 快 10 倍到 20 倍的闪电般数据传输速度。

多接口GPU

使每个 A100 GPU 能够同时运行七个不同的、相互隔离的应用程序或用户会话。

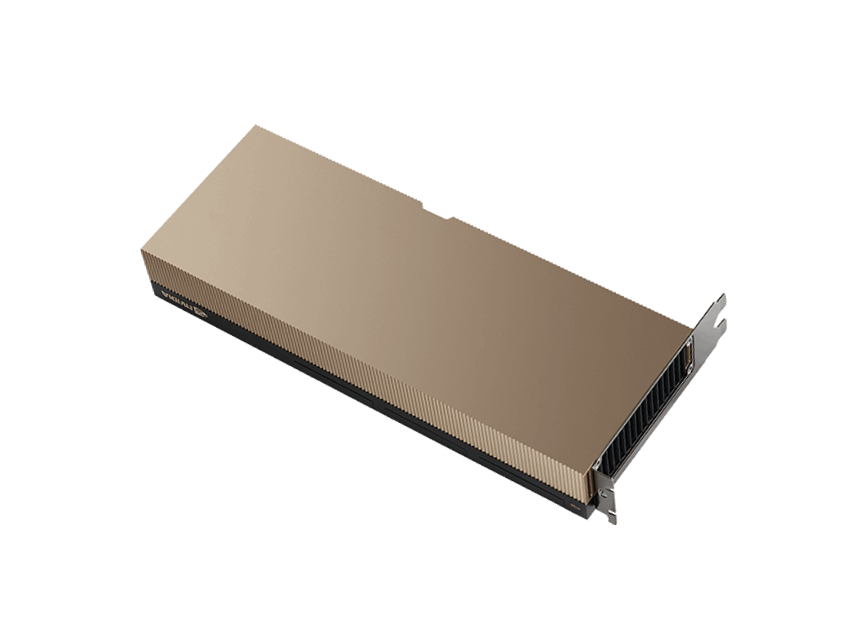

NVIDIA H100 GPU

| NVIDIA H100 技术规格: | |

|---|---|

| 视频内存容量 | 80GB HBM3 |

| CUDA核心 | 8448 件 |

| 最大带宽 | 3 TB/秒 |

| 最新发布的NVIDIA H100 GPU为各种工作负载提供了前所未有的性能、可扩展性和安全性。它的速度至少是其前代产品A100 GPU的两倍。 | |

漏斗基础设施

H100 GPU 在高性能计算应用中表现出色,性能比 A100 GPU 高 7 倍。

连接性

使用 NVIDIA NVLink 交换系统最多可连接 256 个 H100 GPU,从而加速百亿亿次级任务。

人工智能训练

H100 GPU 代表了第四代最先进的 AI 系统,具有卓越的性能能力。

多接口GPU

H100 采用第二代 MIG 技术,可将每个 GPU 安全地划分为最多七个独立的实例。

为什么选择Primcast?

快速发货

付款验证后,A100 即时配置将在 5 分钟内交付。

99.9% SLA

您的 GPU 专用服务器享有业界领先的 99.9% 正常运行时间 SLA 保障。

全天候支持

我们提供实时 GPU 云专家服务,可通过在线聊天、电话和电子邮件联系。

数据中心

您可以从纽约、迈阿密、旧金山、阿姆斯特丹或布加勒斯特部署您的 NVIDIA A100 专用服务器。