Servers in stock

Checking availability...

-

Nvidia A100 H100 Konfigurationen, perfekt für KI, Deep Learning, Visualisierung und High-Performance Computing.

NVMe-Festplatten

24/7-Support

Unschlagbare Preise

5 Minuten Einsatzzeit

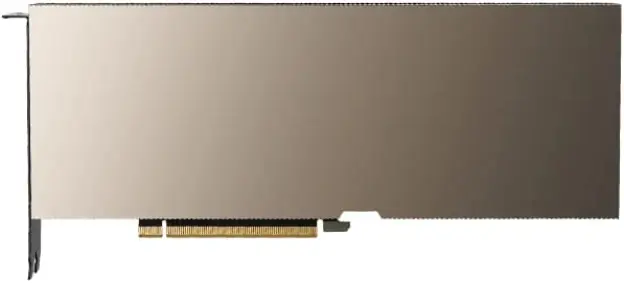

NVIDIA A100 GPU

| NVIDIA A100 Spezifikationen: | |

|---|---|

| Videospeicherkapazität | 40 GB / 80 GB HBM2 |

| CUDA-Kerne | 6912 Stück. |

| Maximale Bandbreite | 1,6 TB/s |

| Die Nvidia A100 GPUs bieten die für KI- und Deep-Learning-Anwendungen notwendige Leistung, Skalierbarkeit und Effizienz und sind damit eine hervorragende Option für Unternehmen und Forscher, die nach modernster Rechenleistung suchen. | |

Ampere-Infrastruktur

Mit 54 Milliarden Transistoren ist die NVIDIA Ampere-Architektur einer der größten jemals gebauten 7-Nanometer-Chips.

Hochbandbreitenspeicher (HBM2)

HBM2 ist so konzipiert, dass es einen schnellen und effektiven Datenzugriff mit einer Speicherbandbreite von bis zu 1,6 TB/s ermöglicht.

KI und Deep Learning

Die Nvidia A100 wurde speziell für Anwendungen im Bereich der künstlichen Intelligenz und des Deep Learning entwickelt und bietet eine bis zu 20-mal höhere Leistung als GPUs der vorherigen Generation.

Raytracing

Erleben Sie Raytracing in Echtzeit – ideal für anspruchsvolle Visualisierungsaufgaben. Die A100-GPU liefert die nötige Rendering-Leistung für realistische und immersive Grafiken.

NVLink-Unterstützung

Nutzen Sie die Möglichkeiten von NVLink der 3. Generation für blitzschnelle Datenübertragungen, die bis zu 10- bis 20-mal schneller sind als mit PCI-Express.

Multi-Interface-GPU

Jede A100-GPU soll in die Lage versetzt werden, gleichzeitig sieben unterschiedliche und isolierte Anwendungen oder Benutzersitzungen auszuführen.

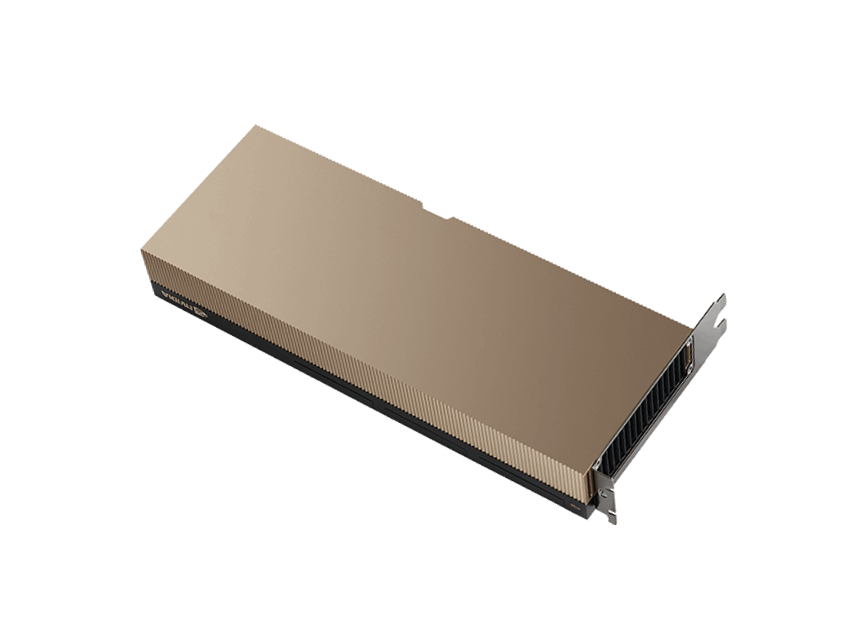

NVIDIA H100 GPU

| NVIDIA H100 Spezifikationen: | |

|---|---|

| Videospeicherkapazität | 80 GB HBM3 |

| CUDA-Kerne | 8448 Stück. |

| Maximale Bandbreite | 3 TB/s |

| Die neueste NVIDIA H100 GPU bietet beispiellose Leistung, Skalierbarkeit und Sicherheit für verschiedenste Anwendungen. Sie ist mindestens doppelt so schnell wie ihr Vorgänger, die A100 GPU. | |

Hopper-Infrastruktur

Die H100-GPUs bieten eine herausragende Leistung in HPC-Anwendungen, die 7-mal höher ist als die der A100-GPU.

Konnektivität

Über das NVIDIA NVLink Switch System können bis zu 256 H100 GPUs verbunden werden, wodurch Exascale-Aufgaben beschleunigt werden können.

KI-Training

Die H100-GPU stellt die vierte Generation des fortschrittlichsten KI-Systems dar und bietet außergewöhnliche Leistungsfähigkeit.

Multi-Interface-GPU

Der H100 verfügt über die MIG-Technologie der zweiten Generation, die es ermöglicht, jede GPU sicher in bis zu sieben separate Instanzen zu partitionieren.

Warum Primcast?

Schnelle Lieferung

Die Konfiguration des A100 erfolgt sofort innerhalb von 5 Minuten nach Zahlungseingang.

99,9 % SLA

Ihr dedizierter GPU-Server ist durch eine branchenführende SLA mit 99,9 % Verfügbarkeit abgesichert.

24/7-Support

Unsere Live-GPU-Cloud-Experten stehen Ihnen per Live-Chat, Telefon und E-Mail zur Verfügung.

Rechenzentren

Stellen Sie Ihren dedizierten NVIDIA A100-Server von New York, Miami, San Francisco, Amsterdam oder Bukarest aus bereit.