Servers in stock

Checking availability...

-

Graças à sua baixa latência, as TPUs são adequadas para aplicações que exigem previsões em tempo real, como sistemas de recomendação e de detecção de fraudes.

As TPUs são otimizadas para o treinamento de modelos complexos como GPT-4 e BERT, reduzindo o tempo e o custo do treinamento.

Pesquisadores acadêmicos e empresariais utilizam TPUs para tarefas como modelagem climática e simulações de dobramento de proteínas, beneficiando-se de seu poder computacional e eficiência.

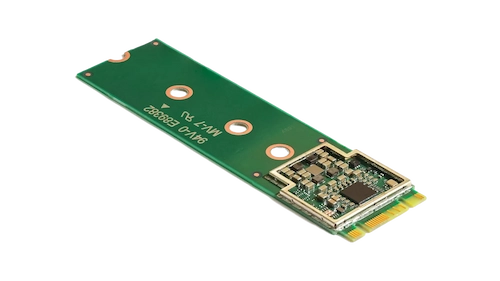

Este acelerador compacto aprimora o aprendizado de máquina no dispositivo, permitindo inferências de alta velocidade com baixo consumo de energia.

Ao incorporar o acelerador Coral M.2 ao seu sistema, você pode obter um processamento de aprendizado de máquina eficiente e em tempo real diretamente no dispositivo, reduzindo a latência e a dependência de computações baseadas em nuvem.

O processador de IA de ponta Hailo-8 oferece até 26 teraoperações por segundo (TOPS) em um formato compacto menor que uma moeda de um centavo, incluindo sua memória.

Sua arquitetura, otimizada para redes neurais, permite aprendizado profundo eficiente e em tempo real em dispositivos de borda com consumo mínimo de energia, tornando-a ideal para aplicações em automóveis, cidades inteligentes e automação industrial.

Este design permite o processamento de IA de alto desempenho na borda, reduzindo custos e consumo de energia.

As TPUs são projetadas especificamente para cálculos com grande volume de matrizes, oferecendo tempos de treinamento e inferência mais rápidos em comparação com as GPUs tradicionais.

Permite o treinamento distribuído em várias unidades. Essa escalabilidade é crucial para o treinamento eficiente de modelos grandes.

Suporta as principais estruturas de aprendizado de máquina, incluindo TensorFlow, PyTorch (via OpenXLA) e JAX, permitindo integração perfeita em fluxos de trabalho existentes.

As TPUs são integradas a serviços como o Google Kubernetes Engine (GKE) e o Vertex AI, facilitando a orquestração e o gerenciamento de cargas de trabalho de IA.