Servers in stock

Checking availability...

-

TPU 具有低延迟能力,适用于需要实时预测的应用,例如推荐引擎和欺诈检测系统。

TPU 针对训练 GPT-4 和 BERT 等复杂模型进行了优化,从而减少了训练时间和成本。

学术界和企业研究人员利用 TPU 进行气候建模和蛋白质折叠模拟等任务,受益于其强大的计算能力和效率。

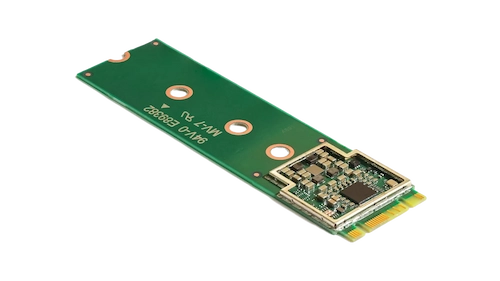

这款紧凑型加速器通过实现高速推理和低功耗,增强了设备上的机器学习能力。

通过将 Coral M.2 加速器集成到您的系统中,您可以直接在设备上实现高效的实时机器学习处理,从而降低延迟并减少对云端计算的依赖。

Hailo-8 边缘 AI 处理器体积小巧,比一美分硬币还小(包括其内存),每秒可提供高达 26 万亿次运算 (TOPS) 的性能。

其架构针对神经网络进行了优化,能够在边缘设备上以最小的功耗实现高效的实时深度学习,使其成为汽车、智慧城市和工业自动化应用的理想选择。

这种设计可以在边缘实现高性能人工智能处理,同时降低成本和能源消耗。

TPU 专为矩阵密集型计算而设计,与传统 GPU 相比,可提供更快的训练和推理速度。

支持跨多个单元进行分布式训练。这种可扩展性对于高效训练大型模型至关重要。

支持主流机器学习框架,包括 TensorFlow、PyTorch(通过 OpenXLA)和 JAX,从而可以无缝集成到现有工作流程中。

TPU 与 Google Kubernetes Engine (GKE) 和 Vertex AI 等服务集成,便于 AI 工作负载的轻松编排和管理。